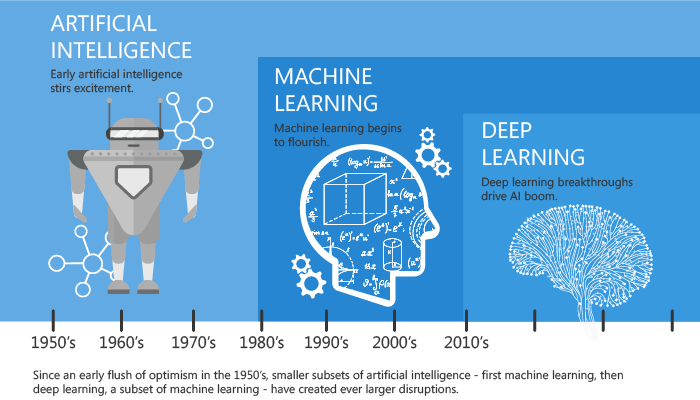

L’Intelligenza Artificiale (IA) sta diventando un tema caldo per i mass-media, pur essendo nata negli anni 50. Fin dall’inizio ha seguito due filoni principali: il primo applica modelli logico/matematici seguendo il metodo scientifico inaugurato da Galileo Galilei e alla base dello sviluppo occidentale degli ultimi secoli, mentre il secondo si fonda su ciò che conosciamo circa il funzionamento della mente umana, da cui il termine “reti neurali” e, più recentemente, “deep learning”.

I progressi pratici di questi due filoni di ricerca sono stati per decenni piuttosto deludenti, specialmente per le reti neuronali. Rispetto al filone concorrente, richiede molti più dati e potenza di calcolo per la fase preliminare di elaborazione del modello, denominata Machine Learning (ML). Si parla di un “lungo Inverno dell’IA” in cui gli studi erano relegati essenzialmente negli ambienti accademici e con limitate applicazioni pratiche.

Perché ora?

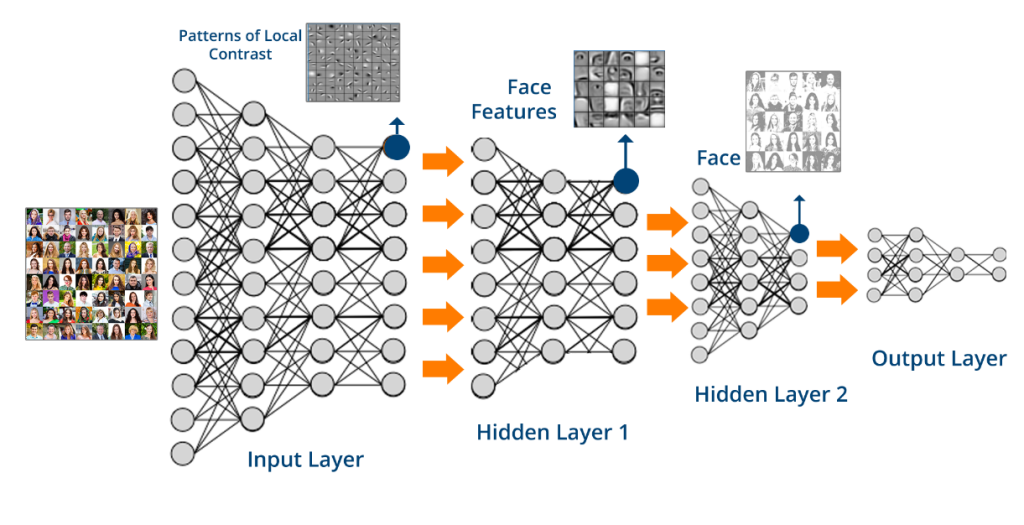

La recente “primavera dell’IA” è merito del Cloud Computing, sia per l’abbondanza di dati da “dare in pasto” alle procedure di ML, che per l’enorme potenza di calcolo disponibile a chiunque sappia come usarla. Il primo a risvegliarsi è stato il filone logico/matematico, ma poco dopo i risultati più eclatanti sono stati generati dai “Deep Neural Network” (DNN), reti neurali dette “profonde” perchè tra i nodi di ingresso e uscita vengono inseriti dei livelli intermedi, ognuno specializzato su un aspetto diverso, moltiplicandone la complessità.

Se il modello elaborato da un algoritmo logico/matematico può ridursi ad un’equazione, quello elaborato dalle DNN è costituito da una serie di matrici con un numero di parametri, da ottimizzare durante l’apprendimento e da valutare in fase di utilizzo, nell’ordine di milioni se non di miliardi.

I salti in avanti nella visione che hanno portato, ad esempio, al riconoscimento di sesso, età e umore di un cliente oppure alla comprensione del senso di intere frasi per instaurare utili conversazioni uomo-macchina, magari con la traduzione automatica tra due lingue, sono solo degli esempi di un rapporto prezzo/prestazioni difficilmente prevedibile 10 anni fa.

I successi sono dovuti sia al progresso scientifico che all’uso di HW specializzato, come ad esempio le GPU (Graphical Processor Unit), nate per gestire i video nei PC perché in grado di elaborare dei sottoinsiemi limitati di istruzioni, ma in modo molto più veloce ed efficiente rispetto alle tradizionali CPU (Central Processing Unit).

Anche nei campi più naturali per i modelli logico/matematici, come ad esempio le previsioni di vendita, si sta diffondendo il filone neuronale con varianti specializzate nell’analisi delle sequenze temporali denominate LSTM (Long Short Term Memory).

Nelle principali aree geopolitiche del mondo ci si è resi conto che l’IA è un potente catalizzatore della Quarta Rivoluzione Industriale in cui siamo già entrati. Gli USA sono stati i pionieri, ma sono stati recentemente raggiunti dalla Cina, almeno in termini di investimenti. In tale competizione, simile a quella per lo spazio tra USA e URSS del secolo scorso, la Cina sta applicando la sua politica dirigistica sui grandi gruppi tecnologici e sugli abitanti che, con i loro comportamenti, forniscono la materia prima per gli algoritmi di IA. Le altre aree geopolitiche sono molto distanziate e rischiano di subire l’egemonia.

Nell’opinione pubblica occidentale si sono innescate apprensioni diffuse sul futuro del lavoro e della nostra civiltà. Circa l’occupazione, poiché la mente umana e l’IA hanno punti di forza e di debolezza complementari, la strada migliore sembra quella della collaborazione uomo-macchina, evitando l’automazione esasperata, spesso anche antieconomica. Sugli impatti a lungo termine non si deve dimenticare che l’aspetto negativo ottiene, al solito, il maggior risalto mediatico. Ciò non toglie che si tratti dello strumento tecnico più potente fino ad ora inventato e che il suo uso richiede una visione etico/filosofica ed una pratica politica in cui l’Europa può dire molto al mondo intero.

Solo nel Cloud?

Mentre il Cloud rimane l’ambiente migliore per la fase di apprendimento, a maggior ragione per le DNN, l’esecuzione si sta spostando in periferia secondo le logiche di Edge e Fog Computing, dove il primo termine identifica il concetto ed il secondo la tecnologia. Portare l’elaborazione il più vicino possibile al punto dove vengono generati e utilizzati i dati, riduce drasticamente la latenza (il ritardo tra invio del dato e ricezione del risultato) ed il volume di dati spostati attraverso internet. Con l’espansione dell’IoT (Internet of Things) i tempi di reazione, la saturazione dei canali di comunicazione e la possibilità di lavorare anche sconnessi sono sempre più essenziali.

Esistono degli standard, tra cui Cafè, TensorFlow e ONNX (Open Neural Network Exchange Format) per merito dei quali i modelli DNN stanno trovando la strada degli smartphone e dei dispositivi ancora meno potenti tipici dell’IoT. Inoltre l’ultima versione di Windows 10 ha introdotto delle nuove interfacce di programmazione per integrare modelli di IA nei PC e Tablet, permettendo l’uso trasparente delle GPU dove disponibili.

Amazon e Microsoft stanno immettendo sul mercato delle telecamere con l’IA a bordo che saranno molto utili nel Retail. Un anno fa avevo ipotizzato che il motivo dei problemi iniziali di Amazon Go (il primo supermercato senza cassieri) potesse essere proprio l’uso di telecamere con l’IA centralizzata nel Cloud http://akite.net/it/news/cosa-puo-essere-andato-storto-nei-primi-test-di-amazon-go

I Deep Neural Network sono solo per le multinazionali?

L’avere a disposizione enormi volumi di dati e potenze di calcolo, oltre a quasi tutte le menti più brillanti in circolazione, favorisce le poche grandi multinazionali che stanno investendo da anni nell’IA.

Tuttavia ciò non impedisce a piccole aziende specializzate di utilizzare le DNN in settori verticali attraverso quella che viene definita customizzazione dei modelli. Diversi colossi dell’IT cominciano a mettere a disposizione degli sviluppatori modelli pronti e semplici strumenti per affinare il processo di apprendimento attraverso pochi esempi specifici.

Nella computer vision questo processo finale di ML consente di prendere in esami decine o centinaia di immagini caratteristiche, evitando l’analisi di milioni di immagini generiche. Nel campo vocale si passa dalla elaborazione di anni di parlato a pochi minuti di termini gergali o dialettali. E’ come se invece di insegnare ad un neonato a svolgere un compito lavorativo, lo si insegnasse ad un giovane che ha già sviluppato le sue facoltà mentali ed ha completato un normale ciclo di studi.

Conclusione

La risposta alla domanda iniziale è positiva: le reti neurali sono attualmente in netto vantaggio. Ma poiché nel corso dei decenni le sorti di diversi algoritmi ed approcci all’IA si sono spesso capovolte, potrebbe succedere ancora. La fine della partita è ancora lontana.

35010 Vigonza (PD)

P.IVA/C.F: 02110950264

REA 458897 C.S. 50.000,00 €

Il software

© Copyright 2023 aKite srl – Privacy policy | Cookie policy